爬虫全教程:仔细 node.js 爬虫全过程!(一)

网络爬虫,以前都语言 Python 做爬虫比较多,现在是时候学习使用 nodejs 爬虫了~由于篇幅过长,本教程分为多节~

工具/原料

电脑

nodejs

本章学习

1、 爬虫过程分析2. 爬虫环境的准备

一、爬虫过程分析

1、① 结构分析分析清楚 需要爬的页面结构,要爬哪些页面,页面的结构是怎样的,需不需要登录;有没有 ajax 接口,返回什么样的数据等。② 数据抓取如今的网页的数据,大体分为同步页面和 ajax 接口。同步页面数据的抓取就需要我们先分析网页的结构,node 有一个 cheerio 的工具,可以将获取的页面内容转换成 jquery 对象,然后就可以用 jquery 强大的 dom API 来获取节点相关数据, 其实大家看源码,这些 API 本质也就是正则匹配。ajax 接口数据一般都是 json 格式的,处理起来还是比较简单的。③数据存储抓取的数据后,会做简单的筛选,然后将需要的数据先保存起来,以便后续的分析处理。当然我们可以用 MySQL 和 Mongodb 等数据库存储数据。为了方便,没有问题的话也可以直接采用文件存储。④数据分析 因为我们最终是要展示数据的,所以我们要将原始的数据按照一定维度去处理分析,然后返回给客户端。 这个过程可以在存储的时候去处理,也可以在展示的时候,前端发送请求,后台取出存储的数据再处理。⑤结果展示这个是前端工程师的工作啦。

二、爬虫环境的准备

1、 下载安装我们使用的是 nodejs 来做爬虫,肯定需要安装好环境 nodejsWindows 安装包(.msi)32 位安装包下载地址 :https://nodejs.org/dist/v4.4.3/node-v4.4.3-x86.msi64 位安装包下载地址 :https://nodejs.org/dist/v4.4.3/node-v4.4.3-x64.msi双击下载好的安装包,按照提示一直安装下去。

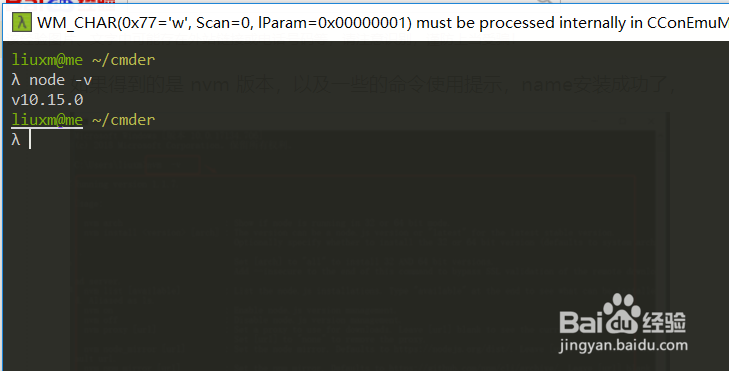

2、 是否安装成功在命令行运行查看是否安装成功```BASH$ node -v# v 10.15.0 这样是安装成功```node:command not found 安装失败了

3、 解谛忖认噤决node:command not found配置环境变量右键桌面我的电脑->属性->高级系统配置->高级->坏境变量还可以这样打开: 炼蓄晦擀电脑开始处搜索 `sysdm.cpl` 打开 ->高级->坏境变量开始配置环境变量,①新建系统变量,`自定义名称 例如:node,地址是 nvm 安装路径`② 创建变量之后还有配置路径 path,点击 path 变量,在这里新建,名称与新建的名称需要一致。配置完环境变量之后,打开一个新的 cmd 运行,`node -v` ,成功得到版本信息就可以了,如果还是不行就重新电脑。再次运行`node -v` ,